Data Orchestration

L'orchestrazione dei dati è un processo automatizzato che preleva dati da molteplici posizioni di archiviazione e consente in modo programmatico di creare, pianificare e monitorare le pipeline dei dati. Le piattaforme di orchestrazione dei dati creano un'orchestra perfettamente in sintonia nella gestione dei dati, offrendoti l'opportunità di controllare i dati, monitorare i sistemi e acquisire informazioni in tempo reale. Gli orchestratori non richiedono script personalizzati, il che alleggerisce il lavoro dei team IT.

Benefici:

- Velocità nel prendere decisioni

- Riduzione degli errori

- Crescita della visibilità delle informazioni

Data Flow

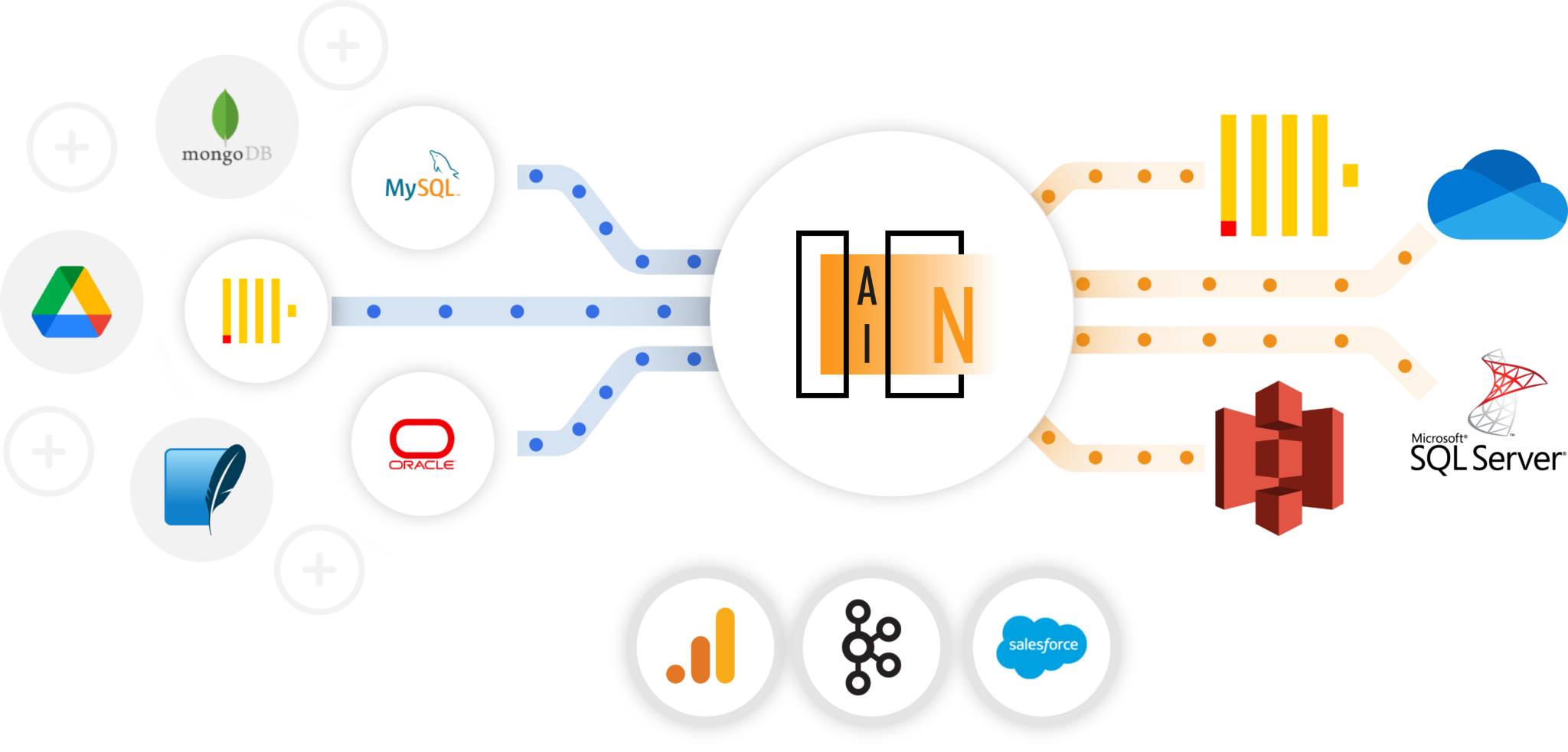

Usa più dati da più fonti, più velocemente

Velocità nel prendere decisioni

Automatizzando ogni fase, gli ingegneri e gli analisti dei dati hanno più tempo per eseguire e trarre informazioni utili, accelerando il processo decisionale.

Read MoreRiduzione degli errori

Un errore comune associato alla pianificazione manuale nel passato era quello di essere soggetti ad errori umani. La programmazione dell'intero processo di pipeline dei dati elimina lo spazio per tali errori.

Read MoreCrescita della visibilità delle informazioni

L'orchestrazione dei dati aiuta a abbattere i silos di dati e rende i dati più disponibili e accessibili per l'analisi. Inoltre, poiché ogni passaggio del processo di orchestrazione dei dati viene eseguito in modo efficiente e rileva gli errori ad ogni stadio, le aziende possono avere fiducia nella qualità dei loro dati.

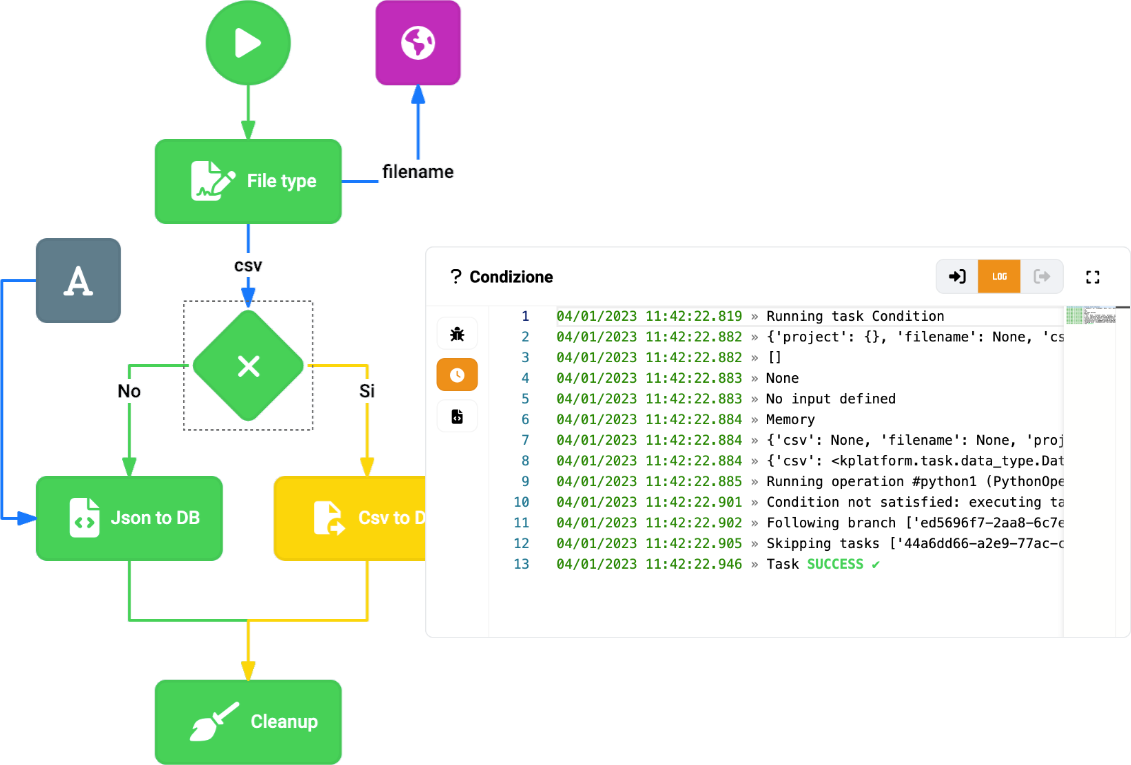

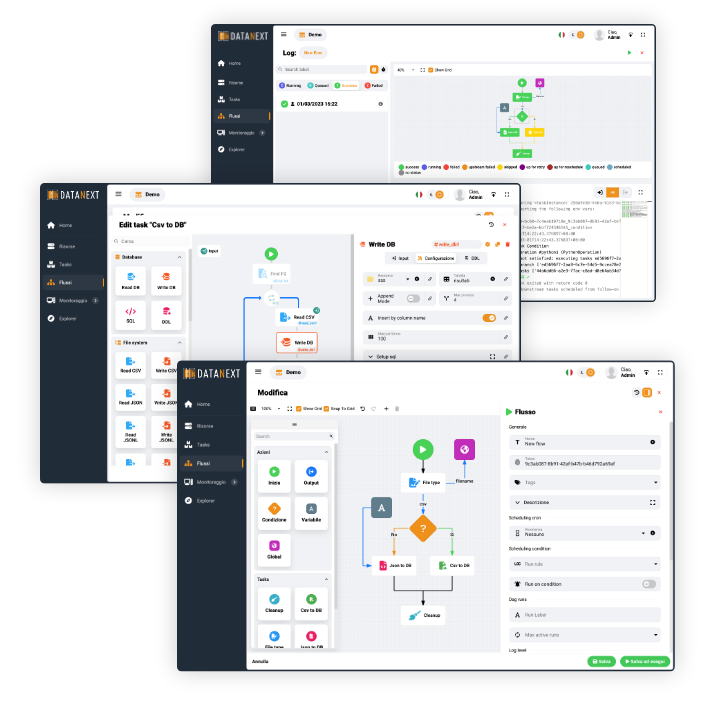

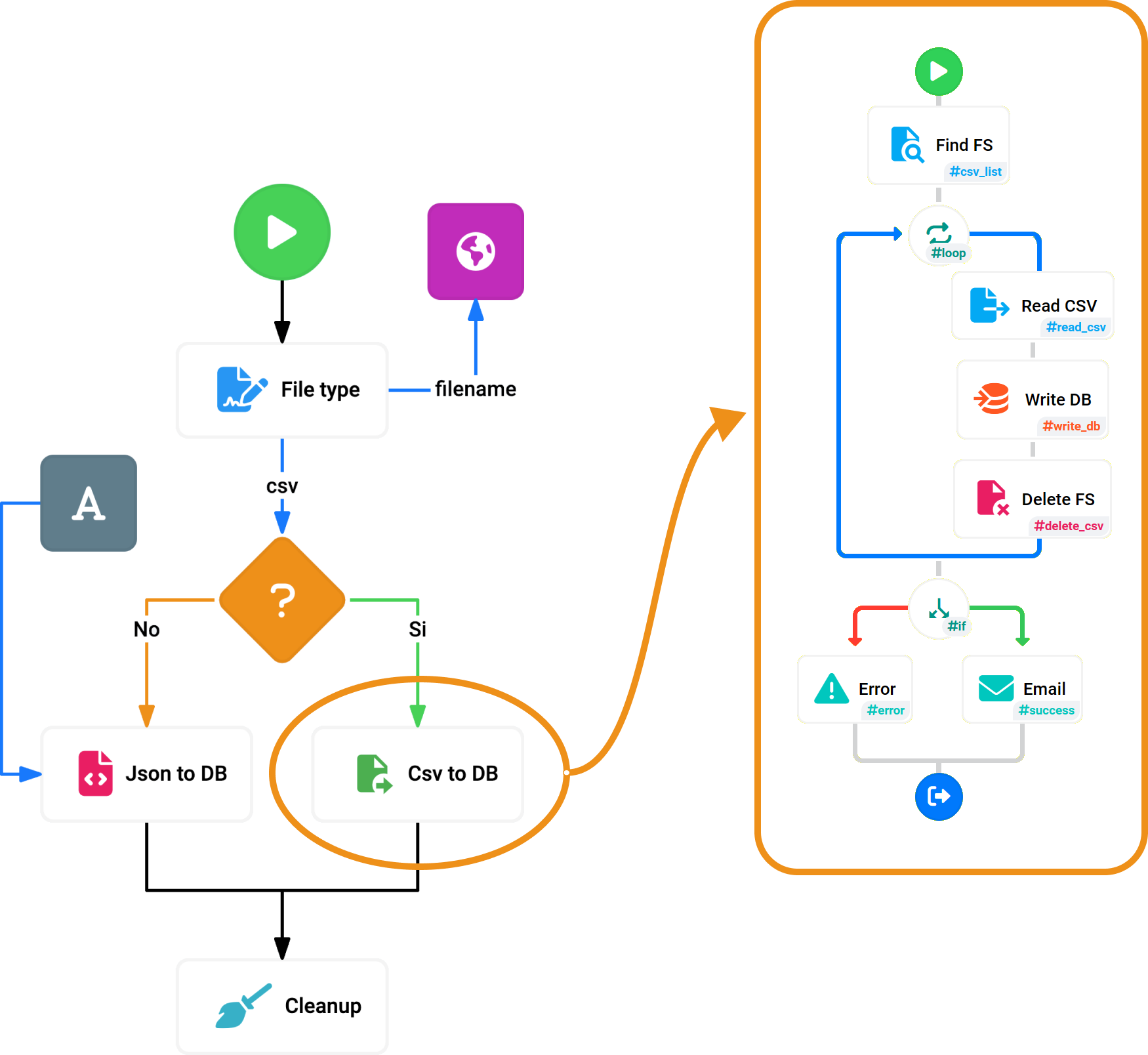

Read MoreOrchestrazione: integra tutto e automatizza in una sola piattaforma unificata. L’orchestrazione dei dati senza codice è facilitata da un intuitivo strumento grafico utilizzato per progettare lo spostamento dei dati, la trasformazione e l’orchestrazione del flusso.

Dotato di una potente interfaccia utente per la creazione e il debug dei flussi, fornisce anche un motore di esecuzione ad alta performance utilizzato ovunque sia necessario lo spostamento e l’orchestrazione dei dati.

Monitoraggio & Logs

Flusso: pannello di diagnostica con una vista completa delle esecuzioni e dei set di dati downstream, utilizzato monitorare l’impatto sull’intero ecosistema dei dati e prendere provvedimenti per garantire che siano effettuati con un rischio minimo.

Processi: controllare lo stato dei processi all’interno di un database. Ottenere aiuto per capire la gerarchia dei blocchi e l’impatto complessivo sulle prestazioni del database.

Logs: monitoraggio e archiviazione dell’esecuzione del flusso di dati per garantire la disponibilità dell’applicazione e valutare l’impatto delle trasformazioni di stato sulle prestazioni.